Deep fake: la notion de vérité est-elle vouée à disparaître

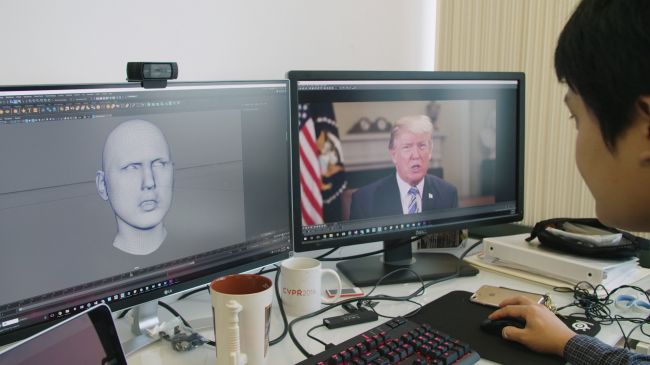

Des spécialistes américains de la sécurité de l'information ont introduit une nouvelle notion de "deep fake", ou "fake profond". Ce terme est apparu pour la première fois en 2017 pour désigner des photos, l'audio, des vidéos et d'autres contrefaçons réalistes créées à l'aide des technologies d'intelligence artificielle (IA). L'usage de fakes profonds pourrait devenir un défi pour la sécurité nationale dans le monde contemporain, ainsi qu'engendrer la méfiance à l'égard de toute information.

Les technologies IA pour la création de fakes profonds continuent de se développer. Leur création se déroule sous la forme d'apprentissage machine. Dans les réseaux adverses génératifs (GAN pour generative adversarial networks) deux systèmes d'apprentissage machine apprennent en concourant entre eux. Le premier réseau ou générateur s'occupe de créer de fausses données telles que des photos, des enregistrements vidéo ou audio qui reprennent les propriétés d'un ensemble de données de référence. Le second réseau ou discriminateur cherche à découvrir des données contrefaites. A l'issue de chaque session le générateur du réseau modifie ses réglages pour créer des données de plus en plus réalistes. La compétition de machine se poursuit sur le réseau des milliers, voire des millions de sessions, tant que le générateur n'améliorera pas les caractéristiques des données à tel point que le discriminateur ne pourra plus distinguer les données réelles des fausses.

A quoi peuvent servir les fakes profonds? Les manipulations dans les médias sont un phénomène qui ne date pas d'hier, mais l'usage de l'IA pour créer des fakes profonds est un passage au niveau supérieur, et les fakes profonds deviennent de plus en plus réalistes. Ils sont créés rapidement et deviennent de plus en plus abordables. Même des opérateurs non qualifiés peuvent télécharger des logiciels et créer un faux contenu de plus en plus convainquant en utilisant des données en accès libre.

La technologie de fakes profonds a déjà été utilisée pour se divertir. Par exemple, des internautes inséraient l'image générée de l'acteur Nicolas Cage dans des films où il n'avait pas joué. Ou encore a été créée une exposition interactive qui incluait des images de tableaux du peintre Salvador Dali qu'il n'avait jamais peints.

Des technologies de fakes profonds ont été utilisées à des fins médicales. De fausses images médicales générées ont été utilisées pour créer un algorithme autodidacte de dépistage de maladies rares.

Bien évidemment, des fakes profonds peuvent servir dans la guerre de l'information, notamment en présentant sur des vidéos falsifiées des représentants publics ou d'autres personnalités qui font des commentaires déplacés ou se comportent d'une manière indigne. Des fakes générés par l'IA sont susceptibles de saper la confiance publique, d'impacter négativement le discours social et même de déterminer l'issue d'un vote.

Des fakes profonds peuvent servir pour faire chanter des responsables ou des personnes ayant un accès aux informations confidentielles. Ils peuvent servir à créer un contenu d'incitation, par exemple, lorsque de fausses vidéos montreront des crimes de guerre qui n'ont pas été commis, des attentats non commis, ainsi que des reportages incitant à la radicalisation de la population, au recrutement de terroristes ou même à une mutinerie et à la violence.

De plus, les fakes profonds créeront une situation où le contenu véridique sera nié en affirmant que c'est un fake profond. Avec le développement des technologies des fakes profonds la notion de véracité et de vérité pourrait disparaître complètement.

Les fakes profonds nécessitent des moyens spéciaux pour leur détection. Cependant, la technologie sophistiquée progresse rapidement vers un point où les fakes profonds seront très difficile, voire impossible à identifier. A l'heure actuelle, la Defense Advanced Research Projects Agency (DAPRA) travaille sur deux programmes destinés à l'identification de fakes - Media Forensics (MediFor) et Semantic Forensics (SemaFor).

MediFor et SemaFor sont considérés comme des moyens d'amélioration de la protection contre les opérations de l'information d'un ennemi éventuel. Il est évident que cette partie du programme restera confidentielle.

En même temps, les experts de la sécurité de l'information pensent que la guerre de l'information mutera dans la compétition de l'autoapprentissage des algorithmes de protection et des algorithmes d'attaque avec la création de fakes profonds. Les générateurs de fakes profonds seront rapidement mis à jour pour pallier les défauts qui permettent de les détecter par des moyens d'identification.

Il est prévu d'utiliser les technologies de protection contre les fakes profonds sur les réseaux sociaux. Ce qui pose la question de responsabilité des acteurs des réseaux sociaux pour la diffusion de fakes profonds. C'est pourquoi les plateformes des réseaux sociaux nécessiteront probablement un élargissement des moyens de marquage et d'authentification du contenu qui y est diffusé. Cela pourrait inclure l'exigence des utilisateurs des réseaux d'indiquer l'heure et le lieu de la création ou de la rédaction de leur contenu.

La prolifération de fakes profonds pourrait finalement apporter une charge excessive sur les plateformes médias sociales ou conduire à une restriction non constitutionnelle de la liberté d'expression. Certains experts affirment qu'il faut se concentrer sur la nécessité d'informer le public au sujet des fakes profonds. Mais la boucle serait alors bouclée. Car cette mesure provoquerait une baisse de la confiance sociale envers toute forme d'information en général.

Bienvenue donc dans un véritable monde de post-vérité.

Alexandre Lemoine

Les opinions exprimées par les analystes ne peuvent être considérées comme émanant des éditeurs du portail. Elles n'engagent que la responsabilité des auteurs

ACTUALITÉS

58% des Français opposés à la nomination de Lucie Castets en tant que Première ministre

Olaf Scholz: «Je n'enverrai pas de soldats en Ukraine»

Suivez-nous sur @ObsContinental